Samsung и SK Hynix могут стать лидерами среди производителей следующего поколения видеопамяти, чипы GDDR7 уже отправлены на тестирование в NVIDIA.

Аналитики ждут роста спроса на память типа HBM благодаря развитию алгоритмов искусственного интеллекта. Память GDDR тоже пользуется немалым спросом, поэтому появления GDDR7 многие ожидают с нетерпением.

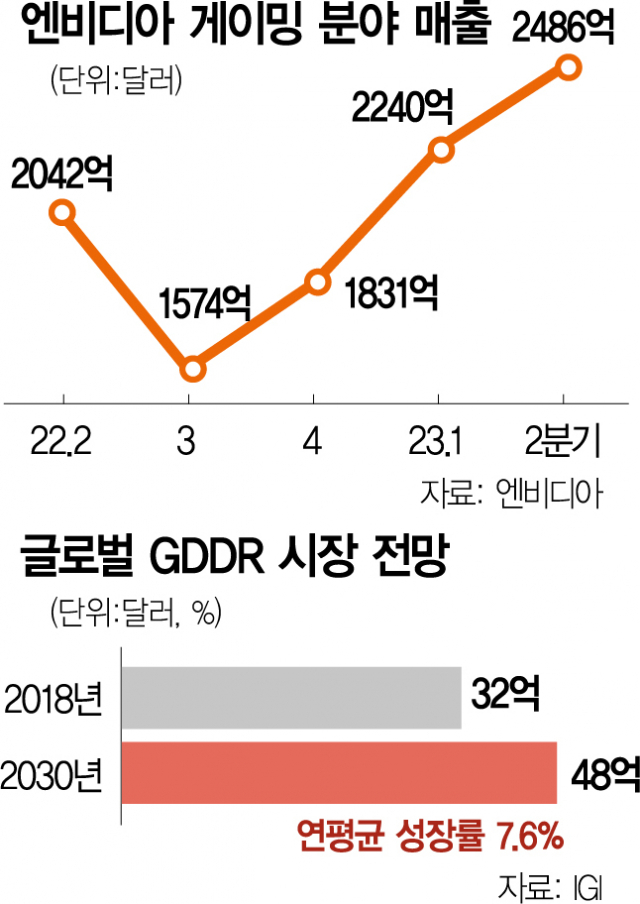

Память GDDR предназначается главным образом для потребительских видеокарт. Исследовательская фирма Industry Growth Insights сообщает, что объём рынка GDDR к 2030 году может увеличиться до $4,8 млрд при ежегодных темпах роста 7,6%. По объёму поставок памяти GDDR6 лидирует компания Micron, а Samsung и SK Hynix сокращают отставание.

GDDR7 от Samsung может предложить увеличение производительности на 40% и энергоэффективности на 20%, Micron немного отстаёт в разработке и её память GDDR7 ожидается к 2024 году.

Будущее поколение видеокарт NVIDIA выйдет только в 2025 году, когда будут представлены графические процессоры Blackwell. Это говорит о том, что у компаний вроде Micron и SK Hynix ещё есть время на совершенствование своей памяти.

возможно буду 5090 брать, давно на нее целюсь

То то нищие умом и кошельком подгорели)

ты настолько нищий, что кроме денег и понтов ничего предложить не можешь?

В 2025 меня ждёт 5080, конкурентов и аналогов как всегда не будет!

наверна крутые будут видеокарты очень интересно. мона будет из узкой шины выжать еще больше фпс если память будет с дополнительными битами для ошибкоустойчивости.

Да коррекция ошибок это то, что очень нужно было современному рынку видеокарт ведь так? Жаль ошибкоустойчивость не распространяется на дизайнеров итоговых решений устройств гпу.

Наверна? Мона?

Мона Лиза???

гонка нынешнего железа не интересна было у меня и 1080ти 2080ти и 3090ти и сейчас 4090ти смысла во всей этой гонке только в собирательстве этого железа трата денег для глаз не чего более

ты как раз себе противоречишь

4090ти? Для тебя специально разработали и изготовили?

Да, на фабрике сказок

у меня до сих пор DDR3

Так Micron потом сразу представит GDDR7X и водяное охлаждение для чипов памяти))

не хватает логотипа "яблоки", каждый год штампуют все новые и новые, а цены летят до Сатурна, только через год приобрел 40 версию с момента выхода, а они уже следующую собираются выпустить, похоже пора уходить с пк гейминга

не каждый год. а раз в два года. с 2016 года нвидиа перешла на двухгодичную систему обновления.

до этого было 4 года. тобиж следующие карты появятся только в конце 2024.

и тебя ни кто не заставляет их брать. топовые и предтоповые карты 30 и 40 серии будут комфортно себе чувствовать еще минимум 3-4 года.

я вот до сих пор на 2080 сижу. и под 1440 мне её вполне хватает. вот как раз возьму себе следующее поколение 50 серии и еще лет на 5-6 забуду о карте.

Не волнуйся, через год-два выйдет про версия консолей - уйдешь из консольного гейминга тоже.

да вообще пора завязывать с этой фуфлой

мда...а у кого то до сих пор GDDR 5X

я только перешел на gtx 1070 ti

А у детей в Конго вообще не какой памяти нету, не GDDR не DDR, так как им приходится с утра до вечера пахать и добывать кобальт!

Помнится шестая память от самсы вышла боком и была головной болью зеленых на старте, потом отказались и вернулись к заказам tsmc, посмотрим какой урок вынесли на этот раз )

Забавно но вся 2000-я линейка на старте была на чипах Микрон!

Ну 3000 не потянули, не хватило времени. Времена пандемии перегруз заказов в tsmc, потому перекинули корейцам и те толком не обкатали, если все пойдет по плану то ничего страшного не будет))

Нет нужды в этой памяти как и в новых картах. На MSI 1080Ti Armor полет более чем шикарный. Включая FSR, отключая вертикалку, хроматическую абберацию и размытость, FPS лупит в потолок во всех играх. А RT в динамике не нужен, никто в онлайн шутерах не смотрит на два отражения в луже и три отражения в окне. А ведь наверняка нашлись дурачки, которые купили 4080 и 4090 на GDDR 6) 5000 серия все равно будет мощнее на 50%+ ну и соответственно 4000 серия будет менее чем в половину стоить.